1. 高并发、高可用复杂系统中的缓存架构有哪些东西?

- 复杂的缓存架构需要支撑高并发、高可用

2. 课程内容-商品详情页的架构?

- 商品详情页系统架构 -> 缓存架构 -> 高并发技术+解决方案+架构 -> 高可用技术+解决方案+架构

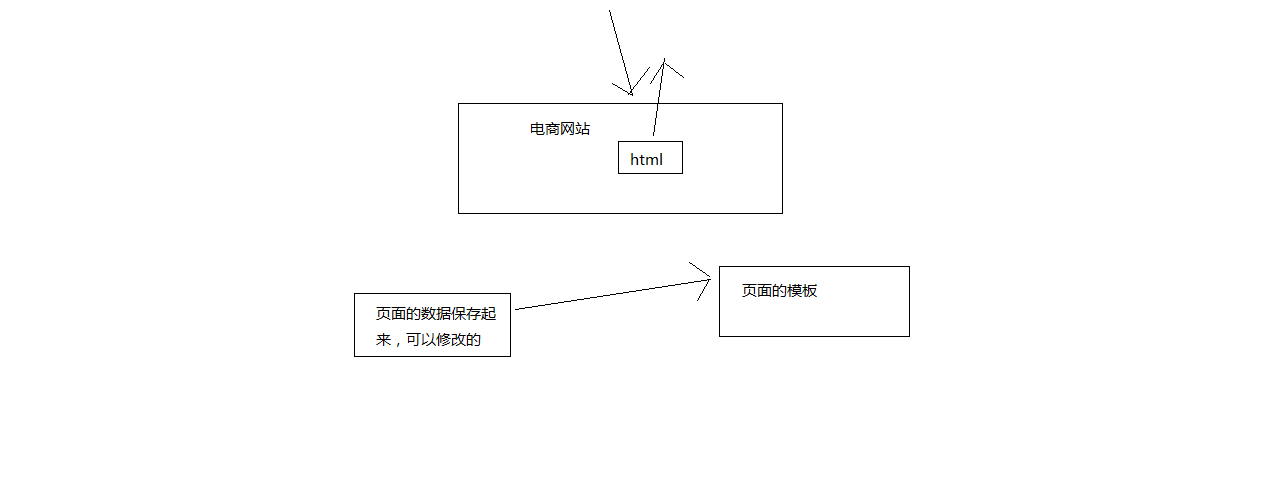

3. 小型电商网站的商品详情页的页面静态化架构及其缺陷?

商品详情页的系统架构 -> 缓存架构 -> 高并发 -> 高可用

小型电商网站架构方案:页面静态化的方案

html模板页面:1

2

3

4

5

6

7

8

9

10

11<html>

<title>

<style css>

<javascript>

</title>

<body>

商品名称:#{productName}

商品价格:#{productPrice}

商品描述:#{productDesc}

</body>

</html>数据存在数据库中 -> 模板的渲染

1

2

3

4

5

6

7

8

9

10

11<html>

<title>

<style css>

<javascript>

</title>

<body>

商品名称:iphon7 plus(玫瑰)

商品价格:5299.50

商品描述:这是最好的手机,大降价了

</body>

</html>模板改变了,这个模板对应的所有数据,全部重新渲染一遍。小网站,页面很少,很实用,非常简单。

大网站,模板上亿,重新渲染,不靠谱。

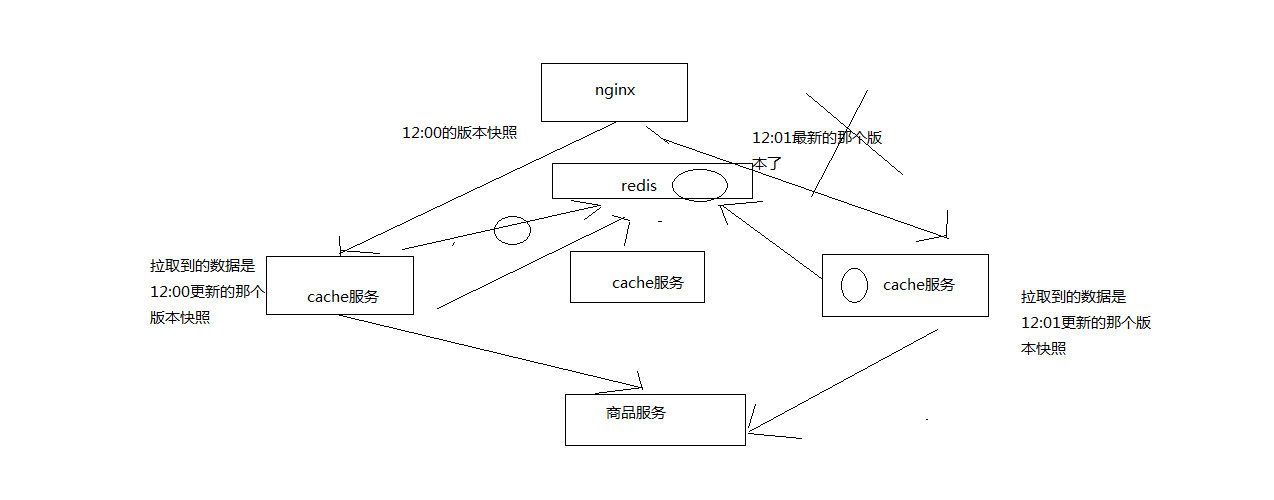

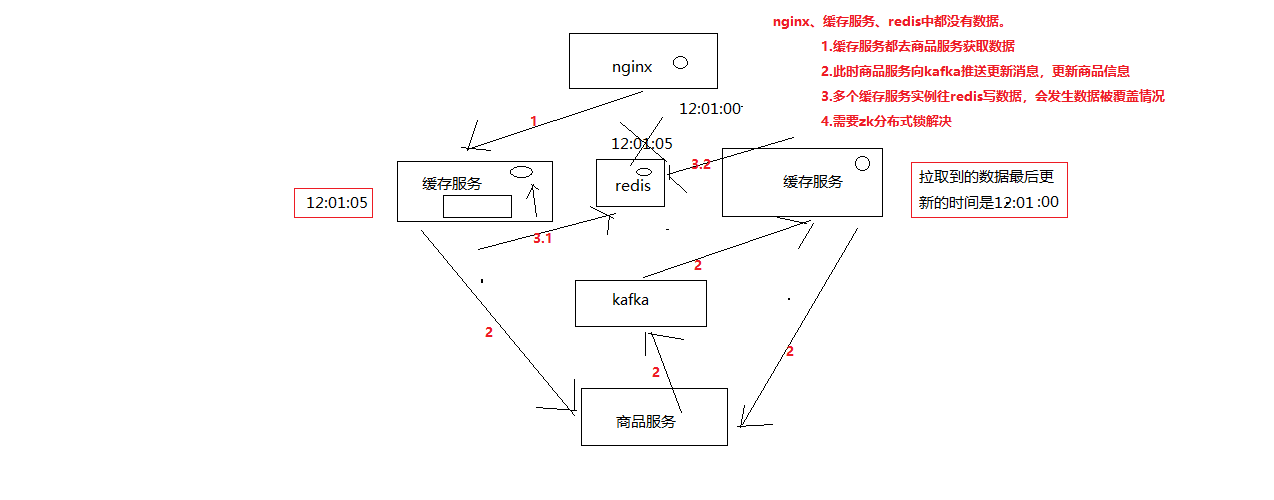

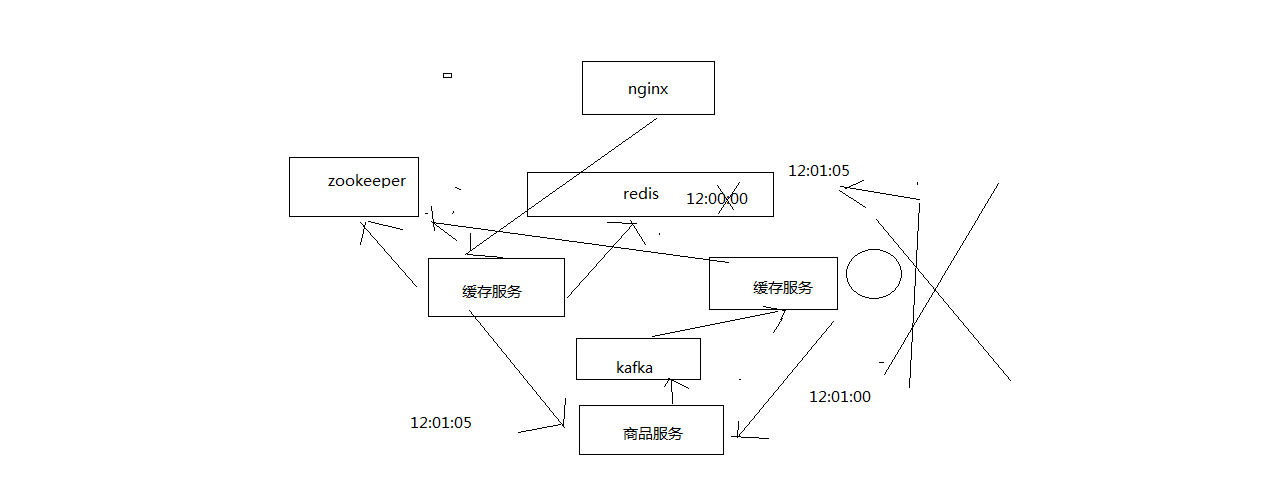

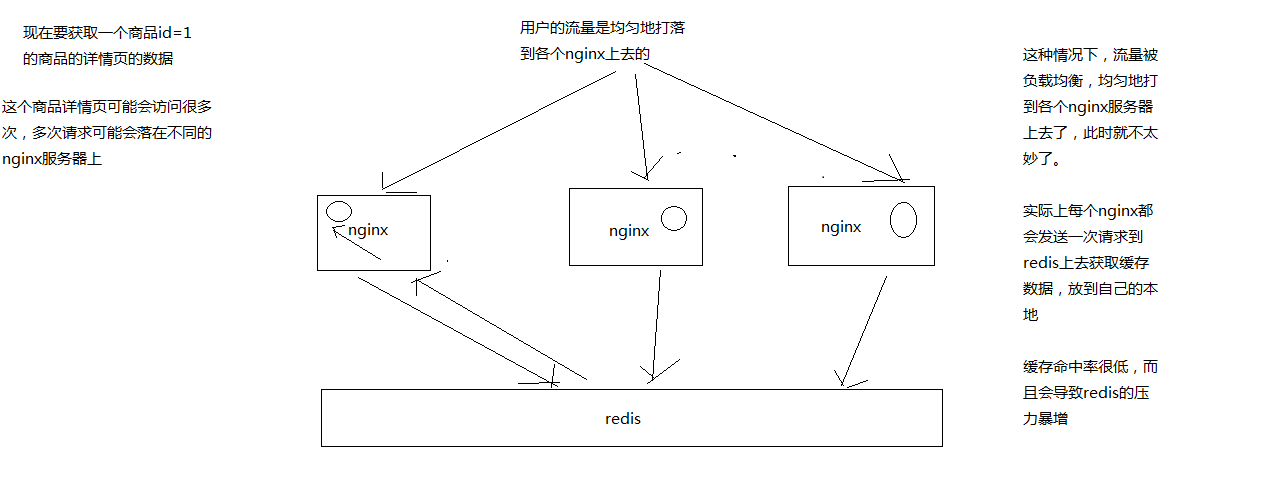

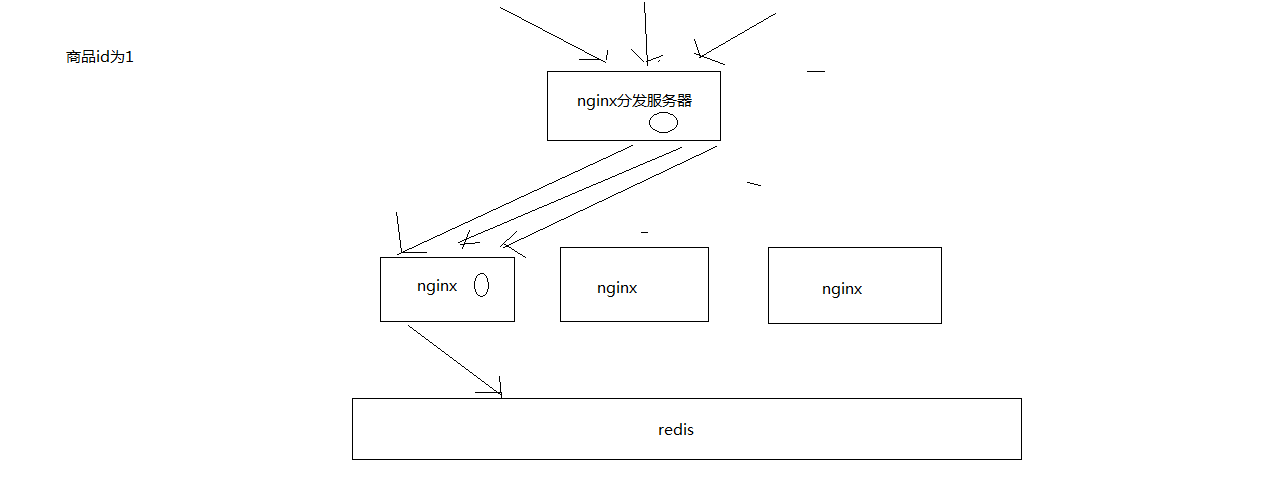

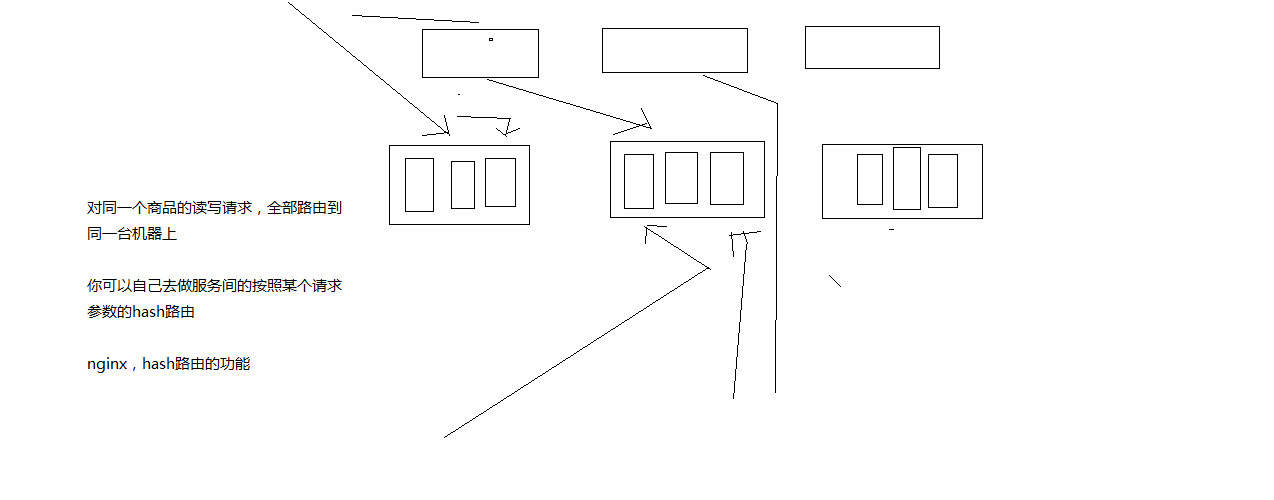

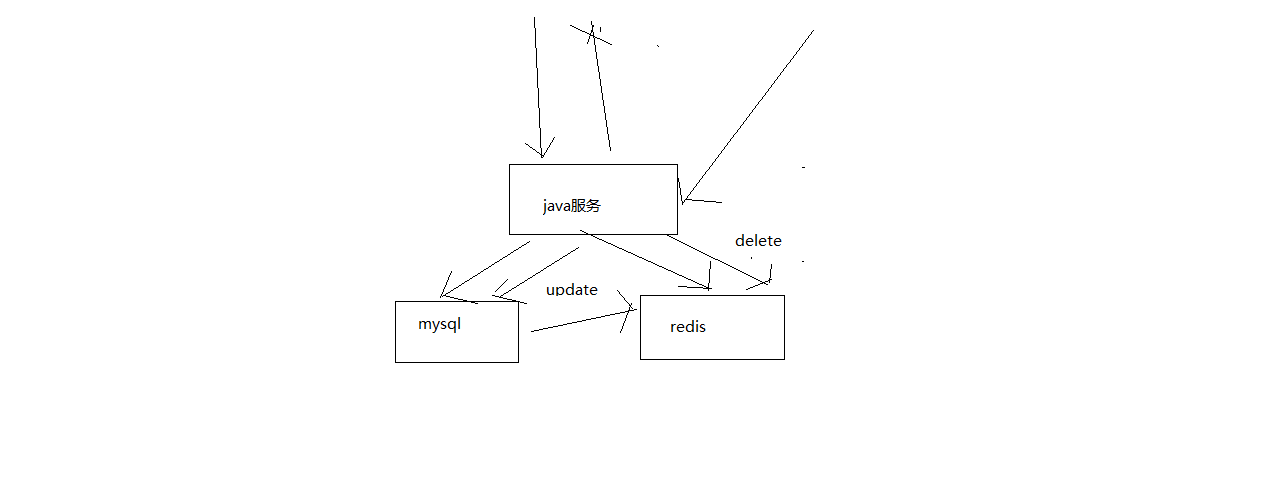

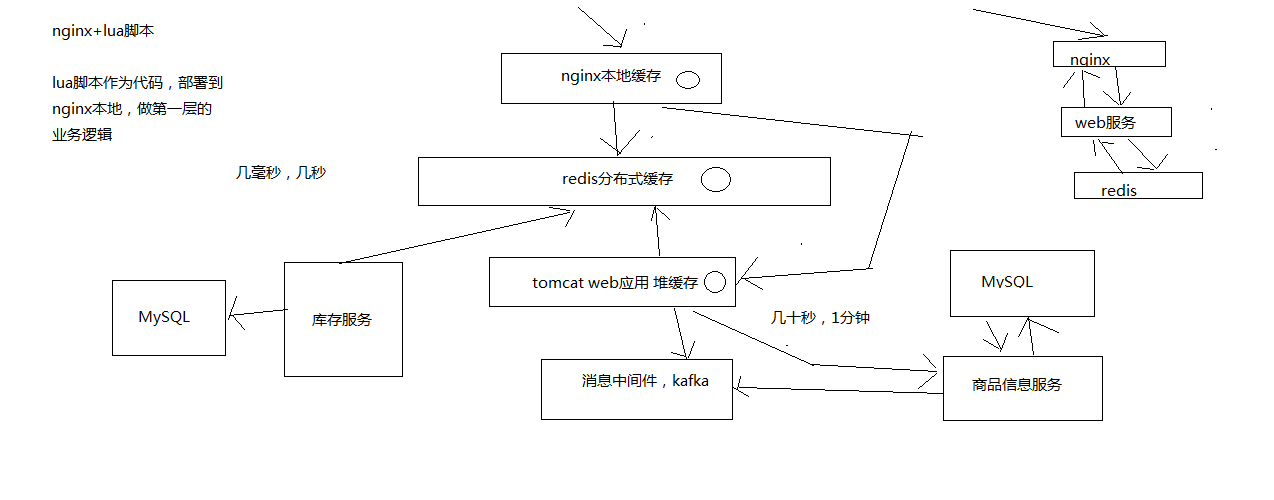

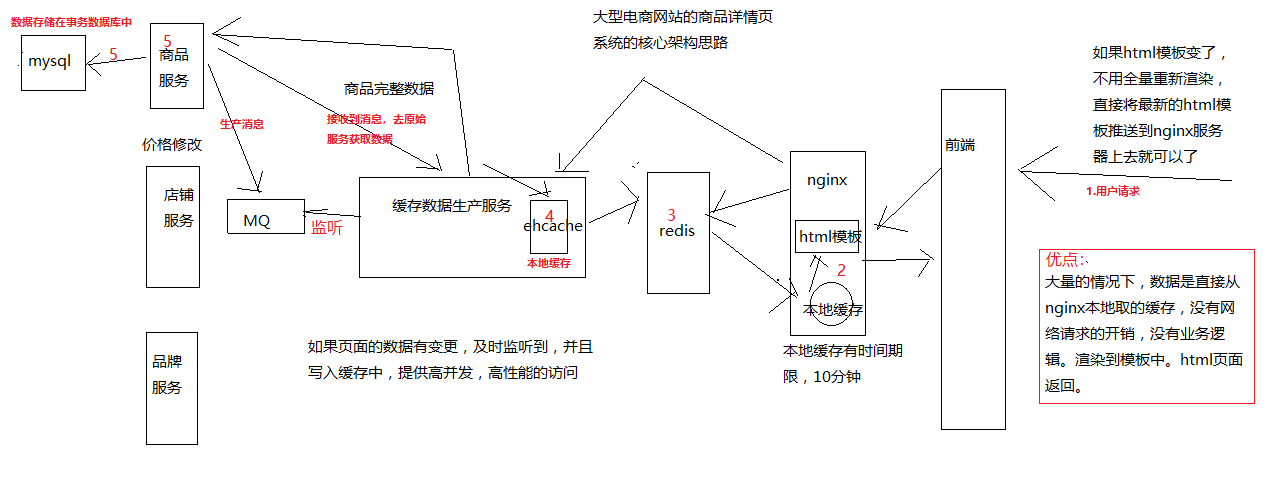

4. 大型电商网站的异步多级缓存构建+nginx数据本地化动态渲染的架构

架构解析:

1. 用户访问页面

2. nignx服务器

2.1 nignx服务器从本地获取数据,如果获取到,渲染html模板;

没有,执行第3步;

3. redis集群

3.1 redis集群从本地获取数据,如果获取到,返回给nignx服务器,nignx服务器将数据写入本地缓存;

没有,执行第4步;

4. ehcache缓存

4.1 ehcache缓存从本地获取数据,如果获取到,返回给redis集群,redis集群写入本地;

redis集群将数据返回给nignx服务器,nignx服务器将数据写入本地缓存;

没有,执行第5步;

5. 去源头获取数据,再一步一步往回执行,写入本地。

5. redis的重要性–首先要掌握redis

支撑高并发、高可用、海量数据、备份恢复的redis的重要性

1. redis架构支持高并发、高可用、海量数据、备份并随时可以恢复。

2. 解决各种各样高并发场景下的缓存面临的难题,缓存架构中不断的引入各种解决方案和技术,解决高并发的问题

3. 解决各种各样缓存架构本身面临的高可用的问题,缓存架构中引入各种解决方案和技术,解决高可用的问题

6. 准备好CentOS集群

7. 单机版redis的安装以及redis生产环境启动方案

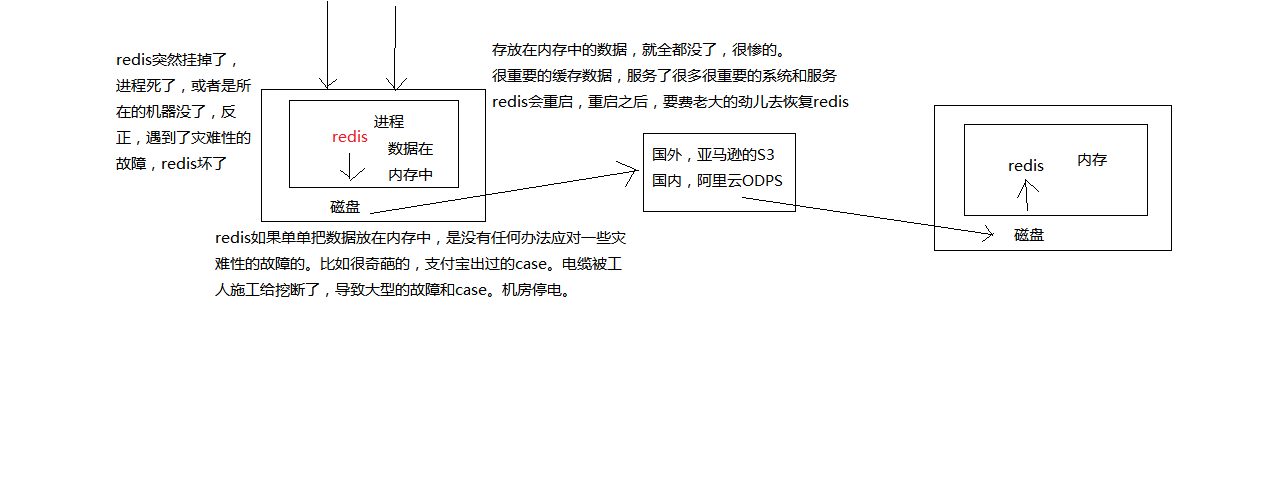

8. redis持久化机对于生产环境中的灾难恢复的意义

redis持久化的意义:在于数据备份,以便于故障恢复。

如果没有持久化的话,redis遇到灾难性故障的时候,就会丢失所有的数据。

如果通过持久化将数据备份在磁盘上,然后定期同步和备份到其它存储上,

那么就可以保证数据不全部丢失,还是可以恢复一部分数据回来的。

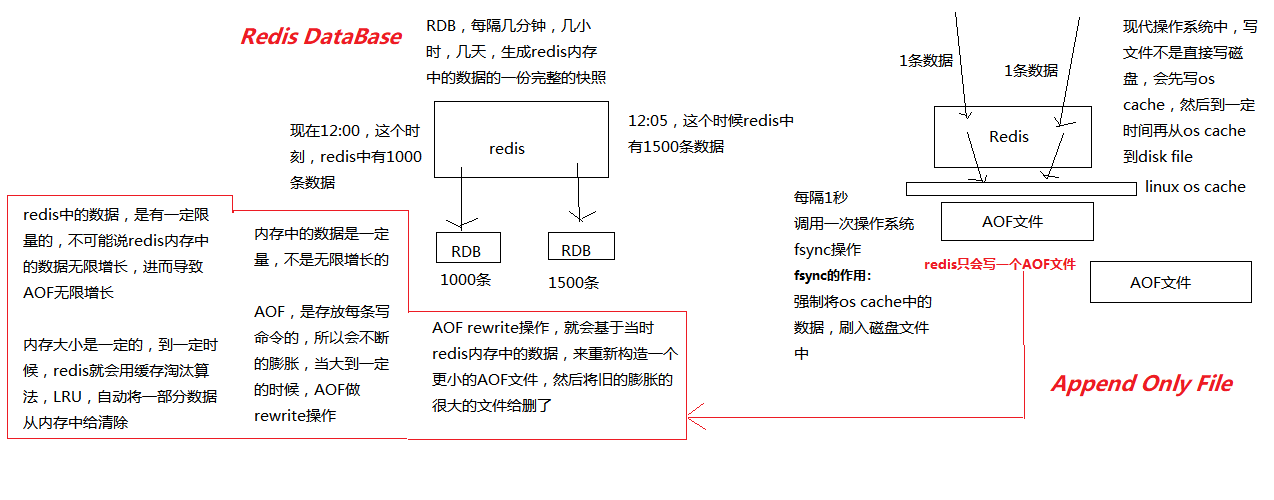

9. redis的RDB和AOF两种持久化机制的工作原理

持久化主要是做灾难恢复,数据恢复,可归类到高可用中。

数据恢复的意义:

>假如redis集群宕机了,redis就不可用了,首要事情是让redis变得可用,尽快变得可用。

>此时重启redis,尽快对外提供服务。

>如果没做数据备份,redis启动了,没有可恢复的数据,redis无法对外提供服务。

>此时大量的请求过来,缓存全部无法命中,请求全部查询数据库,造成数据库宕机,造成缓存雪崩问题。

redis持久化:RDB,AOF。

>`RDB:Redis Database`

>`AOF:Append Only File`

10. redis的RDB和AOF两种持久化机制的优劣势对比

10.1 RDB持久化机制的优点

RDB会生成多个数据文件,每个数据文件代表了某一个时刻中redis的数据,这种多个数据文件的方式,非常适合做冷备,

可以将这些数据文件发送到一些远程的安全存储上去,以预定好的备份策略来定期备份redis中的数据。

RDB也可以做冷备,生成多个文件,每个文件都代表了某一个时刻的完整的数据快照。

AOF也可以做冷备,只有一个文件,但是你可以,每隔一定时间,去copy一份这个文件出来。

RDB做冷备,优势在哪儿呢?由redis去控制固定时长生成快照文件的事情,比较方便;

AOF,还需要自己写一些脚本去做这个事情,各种定时。

RDB数据做冷备,在最坏的情况下,提供数据恢复的时候,速度比AOF快RDB对redis对外提供的读写服务,影响非常小,可以让redis保持高性能,因为redis主进程只需要fork一个子进程,

让子进程执行磁盘IO操作来进行RDB持久化即可。

RDB,每次写,都是直接写redis内存,只是在一定的时候,才会将数据写入磁盘中。

AOF,每次都是要写文件的,虽然可以快速写入os cache中,但是还是有一定的时间开销的,速度肯定比RDB略慢一些。相对于AOF持久化机制来说,直接基于RDB数据文件来重启和恢复redis进程,更加快速。

AOF,存放的指令日志,做数据恢复的时候,其实是要回放和执行所有的指令日志,来恢复出来内存中的所有数据的。

RDB,就是一份数据文件,恢复的时候,直接加载到内存中即可。

结合上述优点,RDB特别适合做冷备份。

10.2 RDB持久化机制的缺点

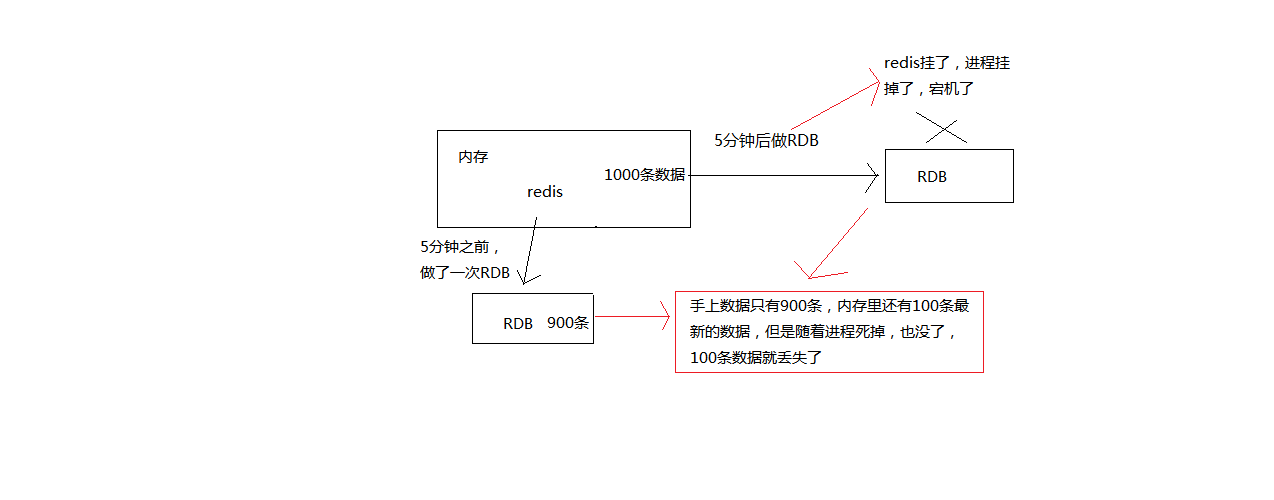

如果想要在redis故障时,尽可能少的丢失数据,那么RDB没有AOF好。一般来说,RDB数据快照文件,都是每隔5分钟,

或者更长时间生成一次,这个时候就得接受一旦redis进程宕机,那么会丢失最近5分钟的数据。

这个问题,也是rdb最大的缺点,就是不适合做第一优先的恢复方案,如果你依赖RDB做第一优先恢复方案,会导致数据丢失的比较多。RDB每次在fork子进程来执行RDB快照数据文件生成的时候,如果数据文件特别大,可能会导致对客户端提供的服务暂停数毫秒,

或者甚至数秒。一般不要让RDB的间隔太长,否则每次生成的RDB文件太大了,对redis本身的性能可能会有影响的。

10.3 AOF持久化机制的优点

- AOF可以更好的保护数据不丢失,一般AOF会每隔1秒,通过一个后台线程执行一次fsync操作,最多丢失1秒钟的数据。

每隔1秒,就执行一次fsync操作,保证os cache中的数据写入磁盘中。

redis进程挂了,最多丢掉1秒钟的数据

- AOF日志文件以append-only模式写入,所以没有任何磁盘寻址的开销,写入性能非常高,而且文件不容易破损,

即使文件尾部破损,也很容易修复

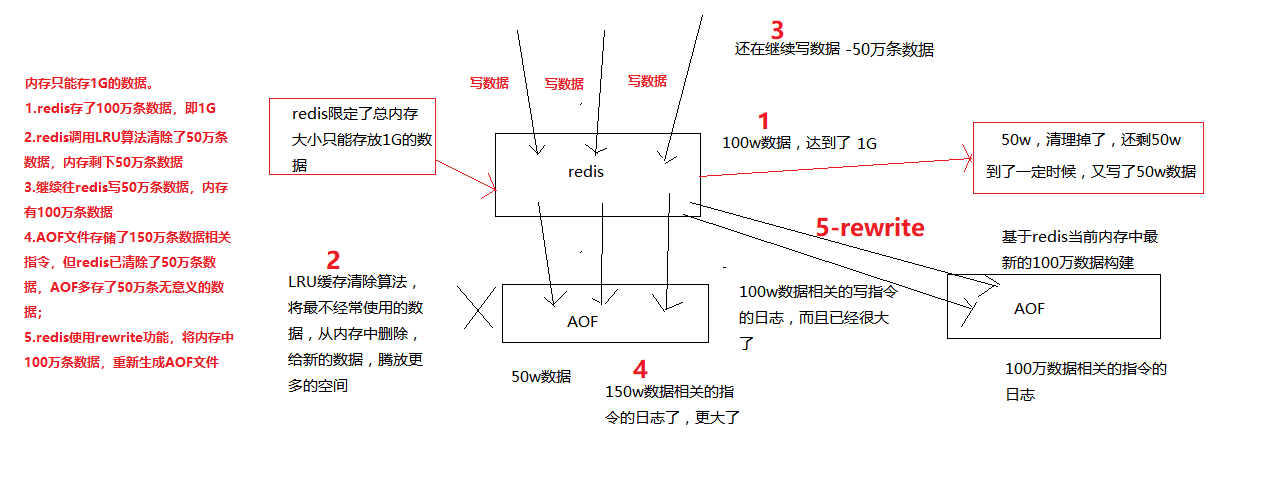

AOF日志文件即使过大的时候,出现后台重写操作,也不会影响客户端的读写。

因为在rewrite log的时候,会对其中的指导进行压缩,创建出一份需要恢复数据的最小日志出来。

再创建新日志文件的时候,老的日志文件还是照常写入。当新的merge后的日志文件ready的时候,再交换新老日志文件即可。AOF日志文件的命令通过非常可读的方式进行记录,这个特性非常适合做灾难性的误删除的紧急恢复。

比如某人不小心用flushall命令清空了所有数据,只要这个时候后台rewrite还没有发生,

那么就可以立即拷贝AOF文件,将最后一条flushall命令给删了,然后再将该AOF文件放回去,

就可以通过恢复机制,自动恢复所有数据

10.4 AOF持久化机制的缺点

对于同一份数据来说,AOF日志文件通常比RDB数据快照文件更大

AOF开启后,支持的写QPS会比RDB支持的写QPS低,因为AOF一般会配置成每秒fsync一次日志文件,当然,每秒一次fsync,

性能也还是很高的。如果你要保证一条数据都不丢,也是可以的,AOF的fsync设置成没写入一条数据,

fsync一次,那就完蛋了,redis的QPS大降以前AOF发生过bug,就是通过AOF记录的日志,进行数据恢复的时候,

没有恢复一模一样的数据出来。所以说,类似AOF这种较为复杂的基于命令日志/merge/回放的方式,

比基于RDB每次持久化一份完整的数据快照文件的方式,更加脆弱一些,容易有bug。

不过AOF就是为了避免rewrite过程导致的bug,因此每次rewrite并不是基于旧的指令日志进行merge的,

而是基于当时内存中的数据进行指令的重新构建,这样健壮性会好很多。唯一的比较大的缺点,其实就是做数据恢复的时候,会比较慢,还有做冷备,定期的备份,不太方便,

可能要自己手写复杂的脚本去做,做冷备不太合适

10.5 RDB和AOF到底该如何选择

不要仅仅使用RDB,因为那样会导致你丢失很多数据

也不要仅仅使用AOF,因为那样有两个问题,

第一,你通过AOF做冷备,没有RDB做冷备,来的恢复速度更快;

第二,RDB每次简单粗暴生成数据快照,更加健壮,可以避免AOF这种复杂的备份和恢复机制的bug综合使用AOF和RDB两种持久化机制,用AOF来保证数据不丢失,作为数据恢复的第一选择;

用RDB来做不同程度的冷备,在AOF文件都丢失或损坏不可用的时候,还可以使用RDB来进行快速的数据恢复